Nous y sommes ! Les IA sont là ! L’IA de YouTube a plus de pouvoir que le président de la république… L’IA de Google choisit ce que vous devez lire et ce que vous devez ignorer… Celle d’Amazon sait avant vous ce que vous allez acheter…

Voulons-nous vraiment donner le contrôle à des boîtes noires dont le fonctionnement nous est obscur ? Moi en tout cas, ça ne me dit rien…

Maintenant qu’on s’est mis dans une telle catastrophe, à nous de reprendre les choses en main ! La remontada de l’espèce humaine est lancée ! Elle s’appelle : explicabilité.

Il est légitime (primordial ?) de vouloir comprendre comment les IA que l’on côtoie fonctionnent, surtout lorsqu’elles ont un aussi grand pouvoir. Car rappelez-vous, ‘’With great power, comes great responsibility’’ (de grands pouvoirs impliquent de grandes responsabilités) c’est l’oncle de Spiderman qui le dit !

La transparence des modèles de machine learning est un des gros challenge de la décennie à venir

Le boom de l’IA et l’adoption rapide par les entreprises des techniques de machine learning, ont apportés de nouvelles questions. Comment interpréter les modèles ? Comment comprendre les résultats fournis ? Il est inconcevable, autant d’un point de vue business que d’un point de vue éthique, de se reposer sur des modèles que l’on ne maîtrise pas de bout en bout. La science ne peut pas fonctionner comme ça…

Imaginez qu’un médecin vous donne un médicament dont il ne connait pas la composition. Imaginez une personne chargée des ressources humaines recruter un candidat sans savoir pourquoi. Ou encore un investisseur qui dépense des millions sur une start-up, seulement parce que son »réseau de neurones »le lui dit. Ce qui est honteux c’est que dans certaines entreprises c’est comme ça que les choses se passent !

Ces comportements peuvent conduire à des situations alarmantes d’un point de vue éthiques. Des algorithmes biaisés peuvent passer entre les mailles du filet. Vous connaissez sans doute le scandale de l’algorithme d’assistance aux juges aux Etats-Unis. Comme les données fournies étaient biaisées, elles ont conduit à un surapprentissage. L’algorithme a fini par considérer le fait d’être noir comme étant un critère important pour le calcul de la probabilité de récidive. De façon similaire, la négligence de Microsoft lors de la conception de Tay, un bot qui interagissait avec les internautes sur Twitter, a fait qu’il est devenu raciste.

Tout ces accidents ont permis une prise de conscience des acteurs de l’intelligence artificielle. C’est pour cela qu’aujourd’hui, l’explicabilité des IA est un des challenges du machine learning les plus à la mode.

Principes de l’explicabilité

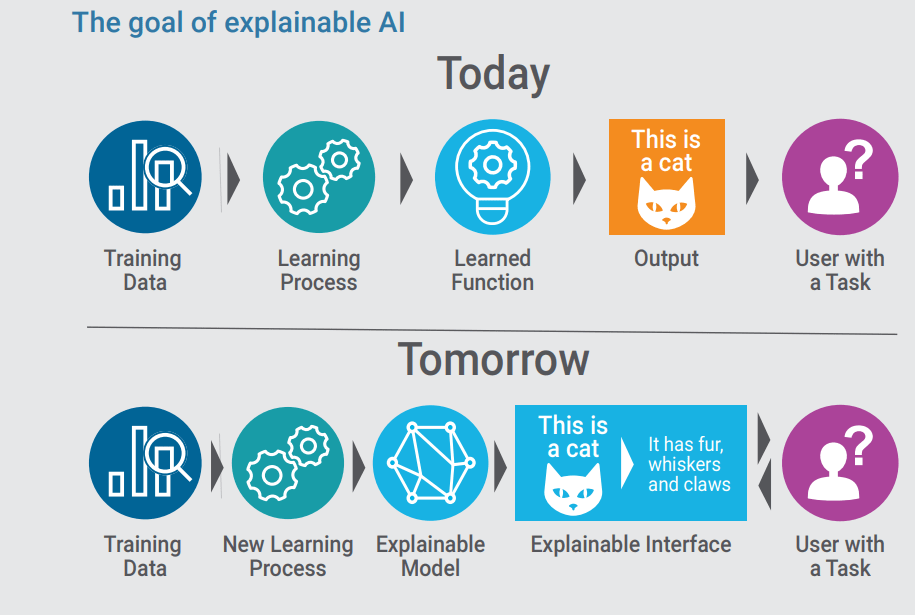

Concrètement, l’explicabilité est un domaine du machine learning qui vise à justifier de la façon la plus précise possible un résultat donné par un modèle.

Par exemple, dans le cas d’un algorithme de reconnaissance de chat, le système doit être capable de prédire si effectivement l’animal observé est un chat et doit être en mesure de dire quels ont été les critères déterminants dans cette décision.

Evidemment, dans ce cas on ne fait que réduire la taille de la boîte noire. La question d’après serait de savoir comment le modèle a reconnu les moustaches (whiskers) ou les griffes (claws) du chat, mais bon je pense que l’on peut déjà se satisfaire d’un tel résultat.

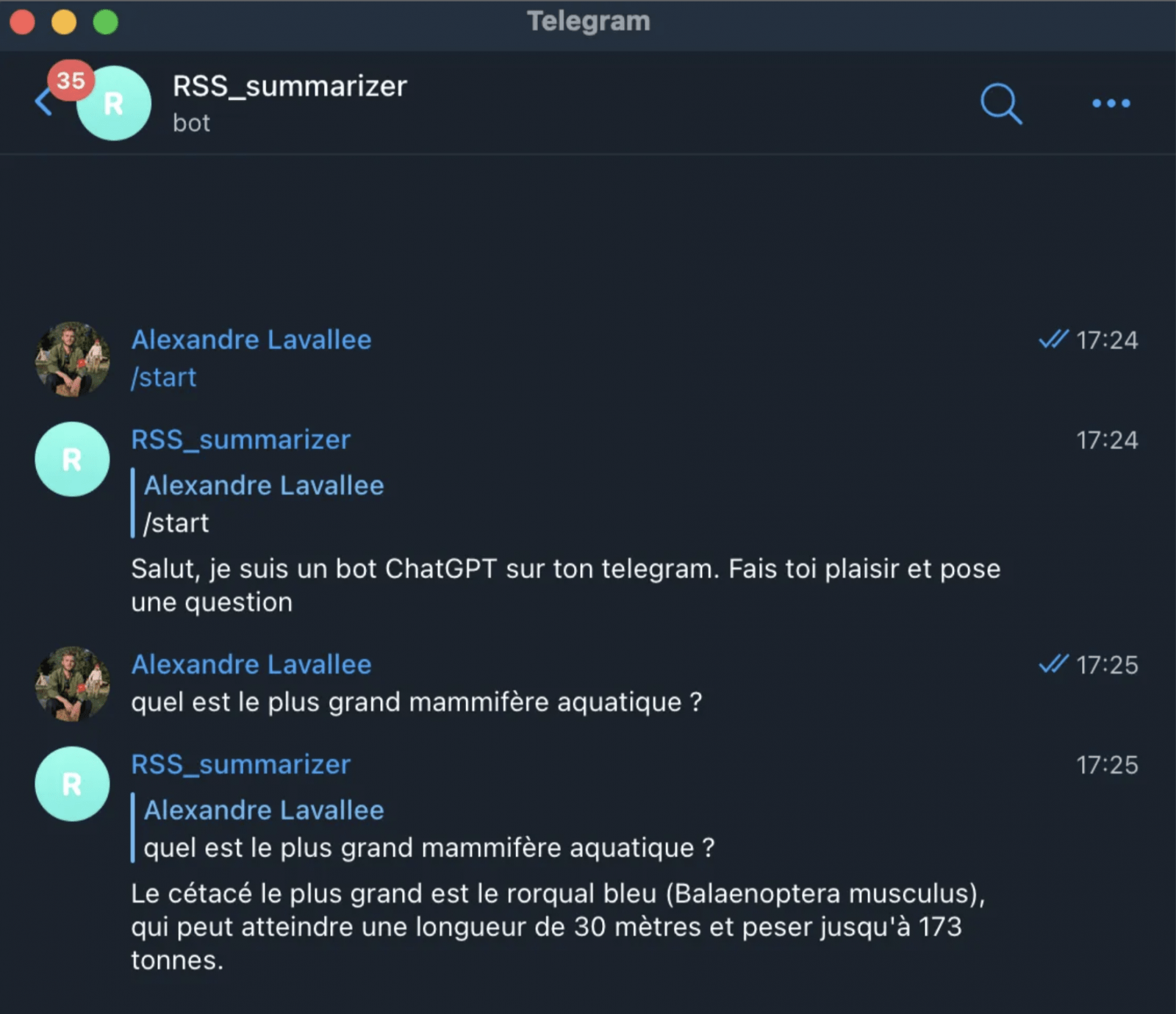

L’explicabilité se développe de façon remarquable. La recherche dans ce domaine est très active et les entreprises investissent de plus en plus sur ces questions. A titre d’exemple, IBM propose des solutions intéressantes aux entreprises qui souhaitent améliorer leurs visibilités sur leur modèles.

Néanmoins, la difficulté qui se pose aujourd’hui est que plus les modèles sont précis, moins ils sont explicables. On cherche donc un compromis. Même si pour beaucoup de data scientist la précision semble être l’indicateur suprême de la qualité d’un modèle, il faut comprendre qu’elle ne fait pas tout. En deep learning par exemple, expliquer les modèles est très difficile. Trouver un algorithme aussi efficace que ceux du deep learning qui en plus est explicable à 100% relève (pour l’instant ?) de l’utopie.

Dans certains domaines comme la santé ou le droit, l’utilisation de modèles de machine learning que l’on ne peut pas expliquer soulève des questions d’éthiques et peut s’avérer dangereuses. Cet aspect devrait être beaucoup plus réglementer. Il pourrait être intéressant de créer un texte similaire au RGPD, mais pour l’explicabilité, qui est une question au moins aussi sensible que la protection des données des utilisateurs.

Très bon article !

Merci Walid ! Vivement le prochain de ta part 🙂